FX168财经报社(北美)讯 周二(2月20日),Groq是最新出现的人工智能(AI)工具,凭借其响应速度和可能无需GPU的新技术,正在席卷社交媒体。

Groq的公开基准测试在社交媒体平台X上疯传后一夜成名,显示其计算和响应速度优于流行的人工智能聊天机器人ChatGPT。

(来源:X)

这是因为Groq背后的团队为大型语言模型(LLM)开发了自己的定制专用集成电路(ASIC)芯片,使其每秒可以生成大约500个tokens。相比之下,该模型的公开版本ChatGPT-3.5每秒可以生成大约40个tokens。

该模型的开发商Groq Inc声称已经创建了第一个运行模型的语言处理单元(LPU),而不是通常用于运行AI模型的稀缺且昂贵的图形处理单元(GPU)。

(来源:X)

在 ArtificialAnalysis.ai最近进行的基准测试中,Groq在几个关键性能指标(包括延迟与延迟)上优于其他8名参与者,包括吞吐量和总响应时间。Groq的网站指出,LPU的卓越性能,尤其是Meta AI的Llama 2-70b模型,意味着“意味着“必须扩展轴才能在延迟与吞吐量图表上绘制 Groq”。

根据ArtificialAnalysis.ai的数据,Groq LPU实现了每秒241个tokens的吞吐量,大大超过了其他托管提供商的能力。这种性能水平是竞争解决方案速度的两倍,并有可能为跨各个领域的大型语言模型开辟新的可能性。Groq的内部基准进一步强调了这一成就,声称达到每秒300个代币,这是传统解决方案和现有提供商尚未接近的速度。

(来源:ArtificialAnalysis.ai)

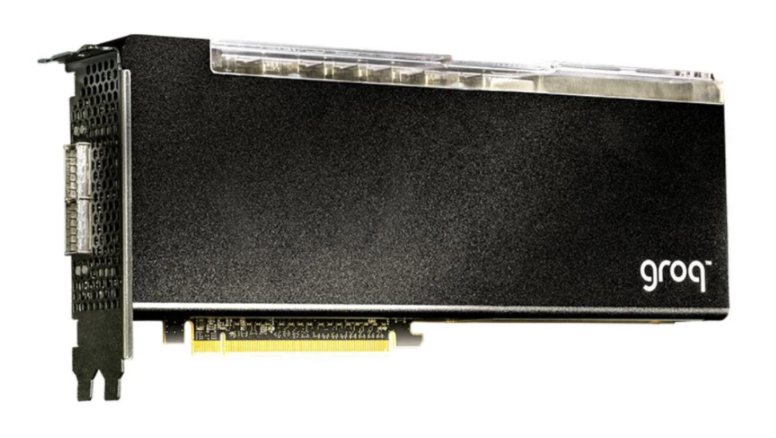

GroqCard加速器是这项创新的核心,售价为19,948美元,可供消费者轻松购买。从技术上讲,它拥有高达750 TOP(INT8)和188 TFLOP(FP16 @900 MHz)的性能,以及每个芯片230 MB SRAM和高达80 TB/s的片上内存带宽,优于传统的CPU和GPU设置,特别是在法学硕士任务中。这一性能飞跃归因于LPU能够显着减少每个字的计算时间并缓解外部内存瓶颈,从而实现更快的文本序列生成。

(来源:CryptoSlate)

将Groq LPU卡与成本相似的英伟达旗舰A100 GPU进行比较,Groq卡在处理大量简单数据 (INT8) 的速度和效率至关重要的任务中表现出色,即使 A100 使用先进技术来提高其性能也是如此。然而,当处理更复杂的数据处理任务(FP16)时,需要更高的精度,Groq LPU无法达到A100的性能水平。

从本质上讲,这两个组件在AI和ML计算的不同方面都表现出色,Groq LPU卡在高速运行LLMS 方面极具竞争力,而A100在其他方面领先。Groq将LPU定位为运行LLM的工具,而不是原始计算或微调模型。

然而,Groq背后的公司并不最近成立的。它成立于2016年,当时注册的商标名为Groq。去年11月,当马斯克自己的人工智能模型(也称为 Grok,但拼写为“k”)受到关注时,最初的Groq背后的开发人员发表了一篇博客文章,呼吁马斯克选择另外的名字。

自从Groq在社交媒体上疯传以来,马斯克和X上的Grok页面都没有对这两个工具名称的相似性发表任何评论。

尽管如此,平台上的许多用户已经开始将LPU模型与其他流行的基于GPU的模型进行比较。

一位从事人工智能开发的用户称Groq是需要低延迟的产品的“游戏规则改变者”,低延迟是指处理请求和获得响应所需的时间。

(来源:X)

另一位用户表示,Groq的LPU可以为GPU提供“巨大的改进”,以满足未来人工智能应用的需求,并表示它也可能成为人工智能“高性能硬件”的良好替代品。

在此背景下,业界主要的人工智能开发商正在寻求开发内部芯片,以避免仅仅依赖英伟达的模型。

据报道,OpenAI正在向世界各地的政府和投资者寻求数万亿美元的资金来开发自己的芯片,以克服产品扩展方面的问题。